人工智能的偏见,是技术上的问题,更是伦理的问题。

人工智能(AI)时代即将到来,从智能手机摄像头的面部识别到自动驾驶汽车、医疗诊断、招聘评估,AI已经深深地融入了人们的生活。然而,AI的判断并不总是公平的。开发者甚至可能没有意识到的数据偏见,导致某些性别、种族或年龄段的群体受到不利影响的情况屡见不鲜。

这些问题的根本原因不在于技术,而在于数据。AI是基于学习数据来理解世界的。但如果这些数据本身存在偏向,或者是在未经同意的情况下收集的,结果无疑也会受到扭曲。为了解决此问题,日本索尼集团的研究机构索尼AI提出了新标准。

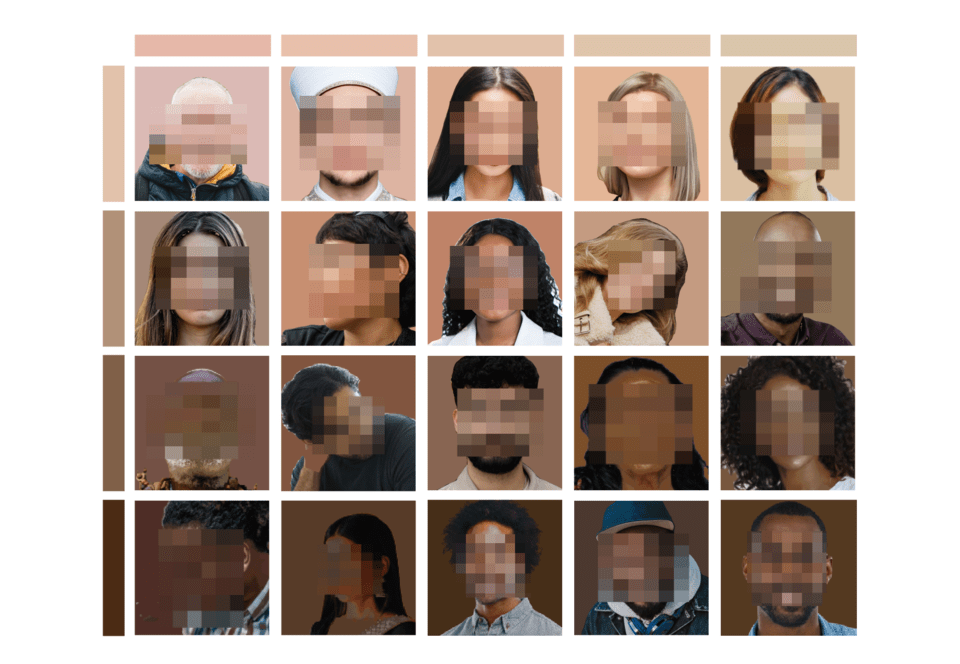

在当地时间5日,索尼AI正式发布了全球首个用于解决人工智能偏见问题的“公正性数据集”,即“公平人本图像基准”(Fair Human-Centric Image Benchmark,FHIBE)。FHIBE旨在检测和改善AI在识别人的面部或身体过程中的偏见性错误。

FHIBE是迄今为止公开的最为严格地遵循伦理程序的数据集。首先,所有照片都是在参与者明确同意的情况下拍摄的。来自81个国家的1,981名参与者提供了总共10,318张图像。这些参与者来自不同的种族、性别、年龄、发型、肤色和文化背景。

索尼AI不仅仅是收集面部照片。每张照片的拍摄环境、光线、相机设置等详细条件都被详细记录下来。研究人员可以利用这些数据精确分析AI模型在特定条件下的偏见。例如,了解AI是否无法在昏暗的光线条件下识别某种特定的肤色,或比起短发更能准确识别长发等。

该项目的开发过程发表在科学期刊《自然》(Nature)上。论文评价FHIBE能够比现有的偏见验证数据集进行更细致和实证的分析。

“人工智能应拓展人类的想象力,而不是扩大偏见。”

索尼集团的AI治理总负责人兼索尼AI的AI伦理负责人Alice Xiang称此次项目为“AI伦理的转折点”。

她指出,“AI产业长期以来一直使用未经同意收集的非多样化数据,结果是AI重现或加剧了社会的不平等现象。”她补充道:“FHIBE证明负责任的数据收集是可能的,我们在信息提供同意、隐私保护、公平报酬、安全性、多样性等所有伦理原则上都进行了应用。”

索尼AI的首席执行官Michael Spranger补充说:“要让AI技术成为扩展人类想象力的工具,首先必须赢得信任。FHIBE是基于公平性和透明性的AI开发的第一步。”

FHIBE不仅是提高准确性的工具,更是检查AI如何看待人类“观念”的工具,这使其意义重大。

FHIBE不仅在数据的收集管理上遵循严格的伦理标准,参与者可以随时删除自己的数据,并且删除后的图像也会尽可能更换为新的数据。此外,即便请求删除,已支付的报酬也不受影响,这种结构保证了数据提供者完全掌控自己的权利。

FHIBE项目历时3年,由全球各地的索尼AI研究人员、工程师及法律、信息技术、质量管理(QA)专家协作开发。在数据收集过程中,经过了法律验证程序,并为隐私保护和公平报酬制定了系统。

索尼AI表示,将持续更新数据集,以免其在时间推移中保持固定形态,并适应AI模型的变化发展公平性标准。

“公平的数据是赢得AI信任的起点。”

AI的公平性和伦理性现在不仅是技术公司可选择的,而是一项必备标准。随着人工智能广泛应用于招聘、犯罪预测、医疗诊断等社会领域,数据偏见直接关联到人的权利问题。

尽管过去许多公司都专注于提高AI的性能,但索尼AI将“公平性”和“透明性”提升为技术的核心价值。FHIBE不仅是研究工具,更展示了未来AI产业应遵循的方向。

索尼AI表示,“AI应扩展人类的想象力与创造力,但这一切的起点必须是表现出对人的公平的视角的数据。”

FHIBE的发布不仅仅是一个数据集,而是为行业各方面阐明了“AI伦理”的解决方案。数据的收集、管理和使用都应融入伦理,那么人工智能才能成为扩展人类想象力而非偏见的技术。