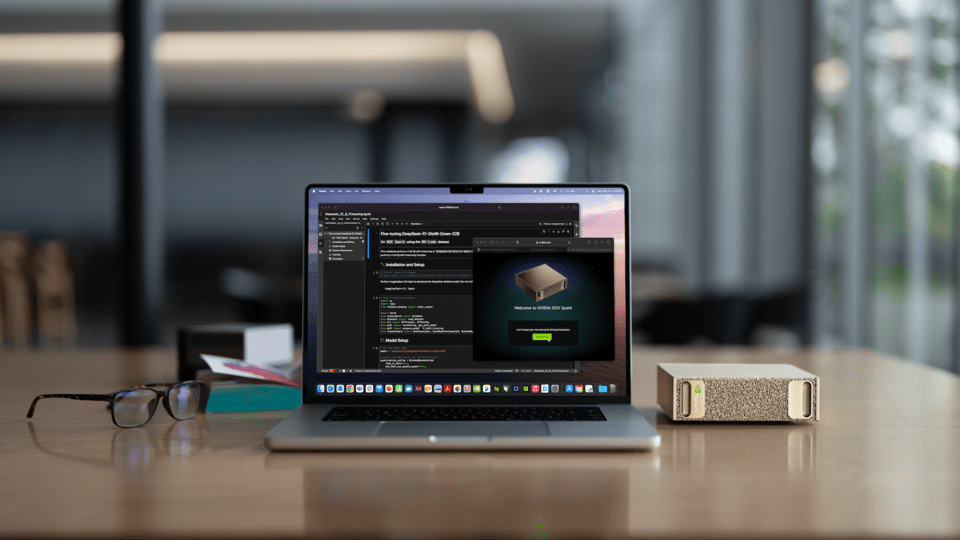

英伟达(Nvidia)将于10月15日(周三)正式发布世界上最小的人工智能(AI)超级计算机‘DGX Spark’。公司表示,该产品将数据中心级别的性能集成到手掌大小的桌面上。其特点是在不需要高价AI服务器或租赁数据中心的情况下,企业和个人开发者能够自主开发和执行AI模型。

DGX Spark内置了英伟达最新的AI专用半导体‘GB10 Grace Blackwell’超级芯片。此外,还配备了超高速数据传输技术‘ConnectX-7’和英伟达的AI操作软件‘DGX软件堆栈’。公司表示,得益于这一组合,尽管系统小型化,却实现了AI数据中心级别的处理性能。

存储容量最高支持128GB,能够运行像大型语言模型(LLM)或图像生成AI等需要大量计算量的AI程序。此外,通过连接两台Spark,能够处理多达4,050亿个参数的大型AI模型。

英伟达解释称,Spark是与华硕(ASUS)和戴尔(Dell)等合作伙伴共同开发的新型计算机产品系列的一部分。英伟达强调:“中小企业或创业公司以及独立开发者无需依赖云,可以在本地环境中直接开发和实验AI。”

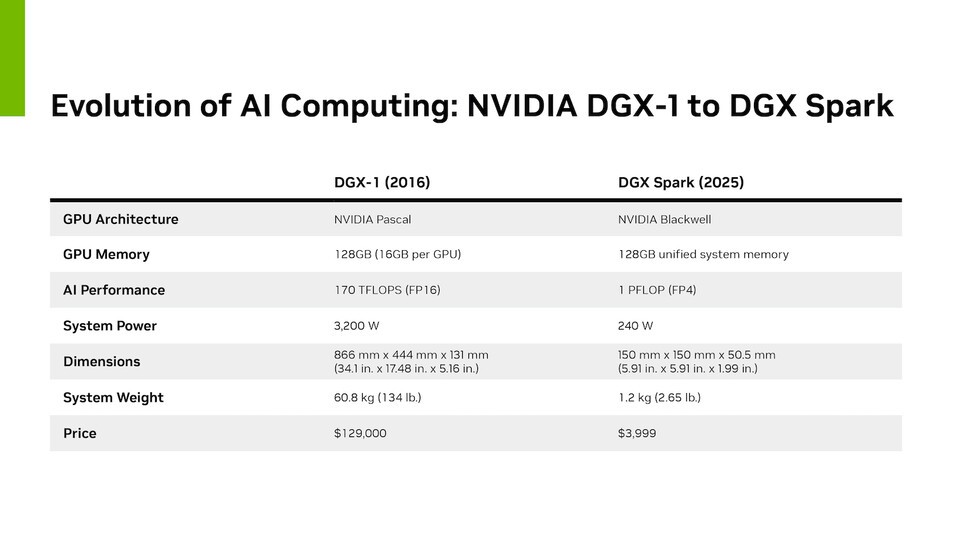

英伟达首席执行官(CEO)黄仁勋(Jensen Huang)表示:“2016年我们为了向AI研究人员提供超级计算机而打造了DGX-1。当时将第一台系统亲自交给了埃隆·马斯克(Elon Musk),从而诞生了ChatGPT。”黄首席执行官还提到,“DGX Spark是将AI超级计算机交到每个开发者手中的又一次跃进。”

英伟达将DGX Spark称为“世界上最小的AI超级计算机”。公司还表示,作为更高端的型号,配备更强大GB300‘Grace Blackwell Ultra’超级芯片的DGX Station也在其中。

不过,DGX Spark和Station并不是像普通电脑一样使用的产品。它们运行英伟自研的基于Linux的操作系统‘DGX OS’,仅针对AI模型的创建和训练进行了优化。无法运行普通的视频游戏或办公软件。

DGX Spark在英伟达的AI生态系统中充当“开发用系统”的角色。用户可以利用Spark进行AI模型实验或原型设计,然后在大型DGX服务器上全面扩展并应用这些模型。

英伟达目前是AI半导体市场的领军企业,建立了以高性能图形处理单元(GPU)和AI软件平台‘CUDA’为中心的生态系统。最近,企业与OpenAI签订了价值1,000亿美元的GPU供应合同,OpenAI计划通过此合同建立10吉瓦(GW)级的AI基础设施。

与此同时,云计算企业CoreWeave也同意从英伟达购买价值63亿美元的GPU。英伟达还向埃隆·马斯克的xAI、亚马逊(Amazon)、谷歌(Google)、Meta、微软(Microsoft)、甲骨文(Oracle)等全球主要IT公司提供GPU。

英伟达期待,本次DGX Spark的发布将成为扩大AI开发可及性的契机。公司表示:“DGX Spark不仅支持大型企业,还支持所有开发者尝试AI创新。”